Page 196 - 信息的脉络

P. 196

·信息的脉络·

Chains)、卷 积 神经 网 络(Convolutional Neural Networks,CNN)、 循环 神 经

网 络(Recurrent Neural Networks,RNN)、长短期记忆网络(Long Short Term

Memory,LSTM)、生成式对抗网络(Generative Adversarial Networks GAN)等。

目前,业界最常用的是卷积神经网络(CNN)、循环神经网络(RNN)。

◆ 卷积神经网络(CNN)

1980 年,日本广播协会基础科学研究所的福岛邦彦(Kunihiko Fukushima)受

到休伯尔和威泽尔的“小猫视觉实验”的启发,提出了“新认知机”(Neocognitron)

的设想,“新认知机”中就已经包含了很多现代卷积神经网络的要素,如卷积、

池化等。

在 1989 年,杨立昆发表一篇名为《通过误差反向传播算法在手写邮政编码识

别上的应用》(Backpropagation Applied to Handwritten Zip Code)的论文,把新认

知机中的概念与辛顿的误差反向传播算法结合到了一起,正式提出了卷积神经网

络。这篇论文基本上是现在业界所认可的卷积神经网络的开端,所以大家认为燕

乐存是卷积神经网络的缔造者。

1998 年,杨立昆又发表了另一篇论文《基于梯度的学习方法在文档识别上的

应用》(Gradient-Based Learning Applied to Document Recognition),在这篇论文中,

杨立昆设计了一个名为 LeNet-5 的神经网络,LeNet-5 网络是卷积神经网络的第一

个具有影响力的完整实现。当年美国大多数银行就是用 LeNet-5 来识别支票上面

的手写数字的,它是早期卷积神经网络中最有代表性的实验系统之一。

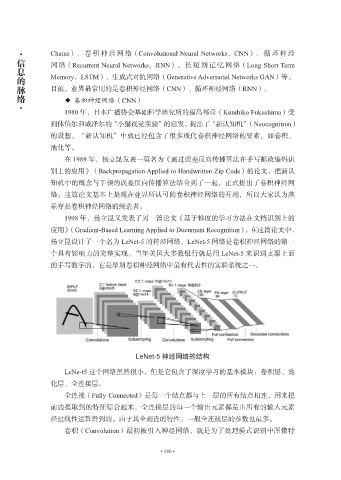

LeNet-5 神经网络的结构

LeNe-t5 这个网络虽然很小,但是它包含了深度学习的基本模块:卷积层、池

化层、全连接层。

全连接(Fully Connected)是每一个结点都与上一层的所有结点相连,用来把

前边提取到的特征综合起来,全连接层的每一个输出元素都是由所有的输入元素

经过线性运算得到的。由于其全相连的特性,一般全连接层的参数也最多。

卷积(Convolution)最初被引入神经网络,就是为了处理模式识别中图像特

• 180 •